![[*]](images/footnote.png) an diese übermitteln.

an diese übermitteln.

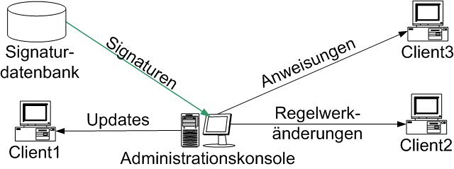

In der Abbildung 2 ist der vereinfachte Aufbau des Systems abgebildet. Der

Administrationsrechner bezog seine Updates automatisch von der Webseite des

Herstellers und versorgte damit die Client-Stationen. Von dieser Konsole konnte

der Administrator die Regelwerke der entsprechenden Clients ändern und auch

bestimmte Befehle![[*]](images/footnote.png) an diese übermitteln.

an diese übermitteln.

Abbildung 2: Der klassische Aufbau einer Sicherheitsinfrastruktur.

Der auf den ersten Blick sichere Aufbau hatte jedoch einige Schwachstellen. Die Versorgung der Client-Rechner mit den aktuellsten Signaturen stellte eine der Komplikationen dar. In der Datenbank des Administrationsservers wurden die von ihm zu betreuenden PCs eingetragen. Dieser prüfte in periodischen Zeitabständen, ob seine Clients online sind und aktuelle Signaturen verwenden. Diese Vorgehensweise führte zu erheblichen Problemen zu Beginn des Arbeitstages, da Hunderte von PCs fast gleichzeitig eingeschaltet wurden. Der Update-Server entdeckte sie und versuchte, die Systeme mit den aktuellen Signaturen zu versorgen. Wurde während des Update-Vorgangs ein neuer Signatursatz verfügbar, fing der Server mit dem Update der Systeme wieder von vorne an. Die Signatursätze der Systeme zu einem Zeitpunkt selten auf dem gleichen Stand. Bei der für Computerviren üblichen rasanten Verbreitungsgeschwindigkeit könnte dies in einer Katastrophe enden. Diese Vorgehensweise bedingte jedoch ein weiteres Problem. Da neue Signaturen kurz nach dem Systemstart eingespielt wurden und das System einen Sicherheitscheck mit den aktualisierten Signaturen vornahm, war der Rechner in der ersten Viertelstunde nach dem Bootvorgang kaum zu bedienen. Die Unternehmensleitung erkannte schnell das "Problem" und man entschloss sich dazu, die PCs nachts laufen zu lassen und es somit auf Kosten der Stromrechnung zu lösen. Die "Lösung" brachte allerdings zwei weitere Probleme mit sich. Obwohl die eingesetzten Büro-PCs für den Dauerbetrieb ausgelegt waren, kam es zunehmend zu den Hardwareausfällen, was zu einer Erhöhung von Reparaturkosten führte![[*]](images/footnote.png) . Ein weiterer Nachteil bestand darin, dass die Systeme jetzt nachts unbeaufsichtigt liefen. Ein weiterer Aspekt ist an dieser Stelle ebenfalls zu erwähnen: Antivirenhersteller können auf neue Angriffe lediglich reagieren. Sobald eine neue Malware bekannt wird, versuchen sie, deren Signatur zu ermitteln und diese an die Kunden weiterzugeben. Diese Prozedur kann Stunden in Anspruch nehmen, was bedeutet, dass in dieser Zeit die Systeme dem neuen Angriff schutzlos ausgeliefert sind

. Ein weiterer Nachteil bestand darin, dass die Systeme jetzt nachts unbeaufsichtigt liefen. Ein weiterer Aspekt ist an dieser Stelle ebenfalls zu erwähnen: Antivirenhersteller können auf neue Angriffe lediglich reagieren. Sobald eine neue Malware bekannt wird, versuchen sie, deren Signatur zu ermitteln und diese an die Kunden weiterzugeben. Diese Prozedur kann Stunden in Anspruch nehmen, was bedeutet, dass in dieser Zeit die Systeme dem neuen Angriff schutzlos ausgeliefert sind![[*]](images/footnote.png) . Ein weiterer großer Nachteil der beschriebenen Infrastruktur bestand darin, dass die Clients nur lokal agiert haben. Um einen akzeptablen Schutz der Systeme zu gewährleisten war man gezwungen, die jeweiligen Scanner-Clients mit dem kompletten Signatursatz und einer eingeschalteten Heuristik laufen zu lassen. Dies führte zu einer schlechten Performance und sorgte für ständige Beschwerden von der Seite der Anwender.

. Ein weiterer großer Nachteil der beschriebenen Infrastruktur bestand darin, dass die Clients nur lokal agiert haben. Um einen akzeptablen Schutz der Systeme zu gewährleisten war man gezwungen, die jeweiligen Scanner-Clients mit dem kompletten Signatursatz und einer eingeschalteten Heuristik laufen zu lassen. Dies führte zu einer schlechten Performance und sorgte für ständige Beschwerden von der Seite der Anwender.

Die beschriebenen Probleme beruhten nicht nur auf der Schwäche der eingesetzten Software und lagen nicht auf der Seite der Administration. Vielmehr waren sie durch den Aufbau des Systems bedingt. Die geschilderten Probleme traten in einem mittelgroßen Netzwerk auf. Bei dem Einsatz in einem größeren Netzwerk wäre eine Eskalation der Situation zu erwarten. Der Einsatz mehrerer Administrationsserver und das dadurch mögliche Load-Balancing würde die Problematik zwar entschärfen jedoch nicht lösen. Einer der größten Nachteile der zentralen Lösung ist die Tatsache, dass zentrale Systeme kritisch für die Funktionsfähigkeit der restlichen Systeme sind. So stellt z.B. der Administrationsserver einen Single Point of Failure dar. Beim Ausfall des Servers können die restlichen Systeme nicht mit den aktualisierten Signaturen versorgt werden. Dasselbe gilt auch für die Systeme des Antiviren-Herstelers. Sobald sie (z.B. aufgrund eines DoS-Angriffs) nicht erreichbar sind, können die Administratoren ihre Signaturen nicht mehr aktualisieren.

Diese und viele andere Probleme Sind mit dem Einsatz der zentralisierten Architektur verbunden. Im folgenden Kapitel werden einige, auf dem Agentenasatz basierende, Konzepte präsentiert, die viele der beschriebenen Schwächen nicht besitzen und trotzdem in der Lage sind, einen angemessenen Systemschutz zu gewährleisten.